IA Act et Enseignement Supérieur

IA Act et Enseignement Supérieur : l’heure de vérité pour les universités

Les obligations du règlement européen sur l’intelligence artificielle transforment les pratiques des universités. Admissions automatisées, notation par IA, surveillance des examens, plugins pédagogiques : l’IA Act impose désormais un cadre strict. Voici l’analyse complète pour sécuriser vos usages.

Comment les établissements doivent sécuriser leurs usages de l’IA avant 2026

L’arrivée du règlement IA Act transforme profondément les pratiques des universités. En moins d’un an, les établissements devront recenser, documenter, encadrer et auditer l’ensemble de leurs outils d’intelligence artificielle, alors même que leurs usages n’ont jamais été aussi dispersés, massifs et stratégiques. Surveillance d’examens, admissions, notation automatisée, recherche fondée sur des modèles, plugins IA intégrés à Moodle : tout entre dans le champ du droit. Je vous propose un décryptage clair et opérationnel des obligations à fort impact pour l’enseignement supérieur, ainsi qu’une feuille de route réaliste pour passer à l’action. Pour approfondir, consultez nos services et avis : www.nathaliedevillier.org.

L’IA Act appliqué aux universités : une transformation structurelle

Le risque est défini par l’usage, pas par l’outil. Autrement dit, un même système peut être classé « minimal » ou « haut risque » selon sa finalité. Cette logique bouleverse la cartographie des outils que les établissements utilisent au quotidien.

Une majorité d’usages classés « haut risque »

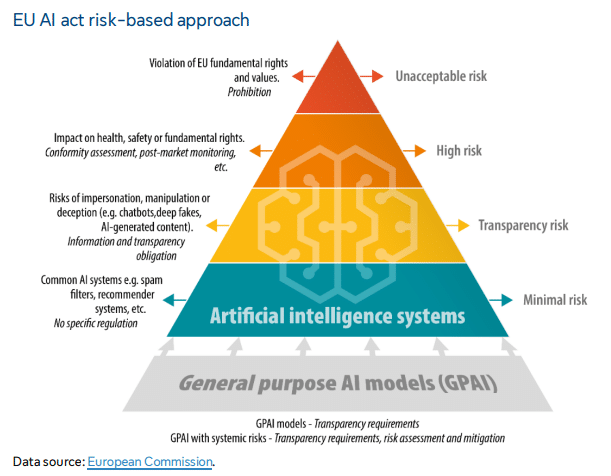

L’IA Act distingue quatre niveaux de risque. Dans l’enseignement supérieur, deux catégories dominent largement :

- Haut risque, notamment pour :

- les algorithmes d’admission ou de présélection des candidatures

- les outils de notation automatisée

- la surveillance d’examens assistée par IA

- les systèmes d’évaluation continue intégrant de l’analyse automatisée

- Risque limité, qui déclenche surtout des obligations de transparence :

- assistants conversationnels

- chatbots d’orientation

- générateurs de textes ou de deepfakes

Un exemple emblématique est celui du fournisseur Proctorio, utilisé pour la surveillance automatisée d’examens. Ce cas cité souligne trois limites majeures : inefficacité, risques de discrimination, atteinte à la vie privée. L’incident impliquant le PDG partageant des échanges étudiants illustre aussi le niveau d’exposition juridique.

Des systèmes pédagogiques et administratifs directement visés

Selon l’Annexe III du règlement IA Act, toute IA utilisée pour l’admission, la notation, ou la surveillance, est automatiquement classée haut risque, quel que soit le fournisseur ou le niveau de sophistication du modèle. L’université d’Essex (UK) a ainsi dû revoir son système d’analyse automatisée des lettres de motivation pour respecter cette obligation.

Cela signifie que de nombreux usages encore banalisés – par exemple des plugins Moodle de création de quiz ou des assistants automatisés de suivi des étudiants – deviennent juridiquement sensibles.

La zone grise de la recherche et la liberté académique

L’IA Act ne s’applique pas à la recherche fondamentale. Mais dès qu’un projet produit ou utilise un modèle destiné à être déployé dans un environnement réel (santé, santé mentale, diagnostic, recommandation), le chercheur devient « fournisseur » au sens du règlement.

Exemple : pour les travaux du LIRIS en IA & santé (Université Claude Bernard Lyon 1), tout modèle de diagnostic relève du statut de dispositif médical et exige un marquage CE. Autrement dit, le chercheur produit un système haut risque soumis aux mêmes obligations que l’industrie.

Cette zone grise impose de renforcer la documentation, d’impliquer les DPO et de former les équipes. Elle se combine avec une exigence forte de protection des libertés académiques, rappelée par le Parlement européen.

Quatre obligations clés : ce qui change vraiment dans les établissements

L’IA Act introduit quatre obligations majeures pour les systèmes haut risque, toutes applicables aux universités.

L’évaluation de conformité avant mise en service

Avant de déployer un système haut risque, l’établissement doit prouver sa conformité, via :

- une évaluation technique (gouvernance des données, qualité, robustesse)

- une évaluation juridique (finalité, base légale, documentation)

Un « tableau Excel » ou un « test informel » ne suffisent plus. Une documentation juridique et technique harmonisée devra être produite.

Le registre IA : la pierre angulaire

Chaque établissement devra maintenir un registre tenant compte :

- des systèmes déployés ou utilisés (fournis par des tiers ou développés en interne)

- de la classification des risques

- du suivi continu (monitoring)

Il ne s’agit pas d’un équivalent du registre RGPD : son périmètre est plus large, plus narratif et plus technique.

Transparence obligatoire auprès des étudiants

Pour toute IA qui évalue, recommande ou influence une décision importante, les étudiants doivent être informés.

Concrètement, cela implique :

- mentions sur les plateformes pédagogiques

- mentions dans les parcours de candidature

- mentions dans les évaluations automatisées

Supervision humaine obligatoire

Aucune décision importante ne peut être prise sans intervention humaine. L’IA ne peut être autonome ni définitive : un humain doit pouvoir corriger, suspendre, contester ou comprendre la décision.

Les nouveaux réflexes institutionnels : gouvernance, contrat, inventaire

Au-delà des obligations de conformité, quatre réflexes sont essentiels pour les établissements.

L’inventaire systématique : une obligation stratégique

La Check-list des 7 questions devient l’outil central :

- Qui l’utilise

- Quelles données

- Quel fournisseur

- Quel niveau de risque

- Quel contrat

- DPO informé

- Documentation à jour

L’exemple du plugin Moodle de « Quiz IA » illustre les dérives possibles : installation sans contrat, données envoyées hors UE, absence d’information du DPO, non-inscription au registre IA.

Le contrat blindé : une protection indispensable

Plusieurs clauses doivent devenir systématiques :

- localisation des données dans l’UE

- garantie de conformité IA Act

- droit d’audit technique

- répartition de la responsabilité

- clause de sortie

L’exemple du contrat Zoom AI Companion démontre l’impact juridique d’une clause d’arbitrage ou de modification unilatérale.

La gouvernance transversale : comité IA + référents

L’idée centrale : l’IA n’est ni un sujet purement technique, ni un sujet purement juridique.

Le modèle idéal repose sur :

- un comité IA trimestriel

- des référents IA dans chaque unité

- un registre centralisé

- une procédure formalisée de validation

- une formation obligatoire

L’enjeu dépasse largement l’amende : il touche à la crédibilité de l’établissement et à ses financements européens.

La formation : le levier le plus rentable

Former 500 personnes coûte moins cher qu’une seule amende. Trois niveaux se dégagent :

- experts (DPO, juristes)

- praticiens (enseignants-chercheurs)

- utilisateurs (étudiants)

Passer à l’action : la feuille de route en 6 mois

Pour permettre aux établissements d’être prêts avant août 2026, la feuille de route proposée est la suivante :

Mois 1-2 : Diagnostic

Inventaire, scoring des risques, gap analysis.

Mois 3-4 : Mise en conformité

Renégociation des contrats, création du registre, documentation.

Mois 5-6 : Pérennisation

Formation, comité IA, audit blanc.

Trois erreurs sont à éviter :

- attendre

- laisser le DPO gérer seul

- interdire toute IA

Ces trois postures conduisent à des risques accrus, une perte de compétitivité académique et une incapacité à absorber les exigences du règlement.

La conformité IA comme levier d’excellence

Pour les universités, l’IA Act n’est pas seulement un cadre juridique : c’est une opportunité. Il permet :

- d’améliorer la confiance des étudiants

- de garantir l’intégrité académique

- de renforcer l’attractivité internationale

- de sécuriser les financements de recherche

Il s’agit d’un changement de culture. Les outils doivent être structurés, contractuellement sécurisés, gouvernés et documentés. Les établissements qui commenceront tôt seront ceux qui disposeront d’un avantage comparatif.

Définitions utiles

Système d’IA à haut risque : système soumis aux obligations les plus strictes de l’IA Act en raison de son impact sur les droits fondamentaux ou la sécurité.

Supervision humaine : capacité pour un humain de contrôler, corriger ou invalider une décision prise par un système d’IA.

Registre IA : document institutionnel recensant les systèmes IA utilisés, leur classification, leur documentation, leurs fournisseurs et leur suivi.

Shadow IT : installation ou utilisation non autorisée d’outils technologiques, souvent sans validation du DSI ou du DPO.

Sources externes pertinentes

- Rapport Sénat – Libertés académiques (2021)

https://www.senat.fr/notice-rapport/2020/r20-873-notice.html - EPRS – Academic Freedom Monitor (2025)

https://www.europarl.europa.eu/RegData/etudes/STUD/2025/765775/EPRS_STU(2025)765775_EN.pdf - CNRS – La recherche française face à ChatGPT

https://www.cnrs.fr/fr/actualite/la-recherche-francaise-face-chatgpt